主理人说

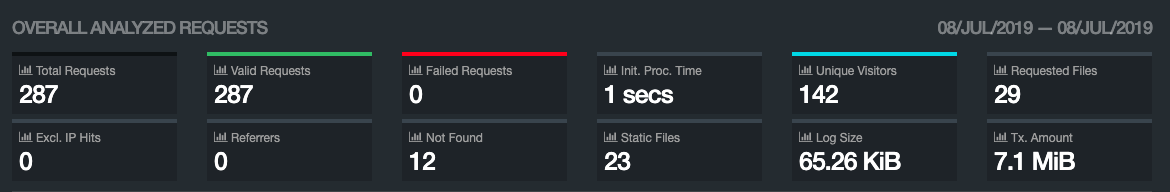

本站已于7月8日晚10点正式开启可视化Web日志分析工具,你可随时查看我们网站的访问记录。地址:https://limbopro.com/results.html (样例)

access.log 里面简直就是一个宝藏。学习分析它,或许会对爬虫索引与网站优化有些许好处。至少你会知道哪些页面被检索到,但打开时已经是404页面。当然,如果网站有被人攻击,那么分析access.log也是可以借机封禁一些过分IP的。

GoAccess 是什么

GoAccess 是一款开源的且具有交互视图界面的实时 Web 日志分析工具,通过你的 Web 浏览器或者 linix 系统下的终端程序(terminal)即可访问。

能为系统管理员提供快速且有价值的 HTTP 统计,并以在线可视化服务器的方式呈现。

安装与使用

源码安装(示例)

$ wget https://tar.goaccess.io/goaccess-1.3.tar.gz

$ tar -xzvf goaccess-1.3.tar.gz

$ cd goaccess-1.3/

$ ./configure --enable-utf8 --enable-geoip=legacy

$ make

$ make installapt-get安装

Debian/Ubuntu

apt-get install goaccess如何安装最新版本

$ echo "deb http://deb.goaccess.io/ $(lsb_release -cs) main" | sudo tee -a /etc/apt/sources.list.d/goaccess.list

$ wget -O - https://deb.goaccess.io/gnugpg.key | sudo apt-key add -

$ sudo apt-get update

$ sudo apt-get install goaccess其他系统安装参考

使用语法

https://goaccess.io/man

语法举例

CD进入日志所在目录,执行命令:goaccess -f access.log,如果你不知道你的 access.log 在哪里?或许你应该先熟悉一下lnmp各软件的安装目录。或者使用 find 命令查找一下,find / -name "access.log",我这里搜索到的是/home/wwwlogs/access.log,所以这样分析goaccess -f /home/wwwlogs/access.log。

常用语法

$ goaccess -h #查看帮助

$ goaccess -f /路径/access.log参阅源码安装全攻略:使用goaccess对Nginx日志简单分析.pdf

日志统计分析常用命令

所有HTTP状态及次数统计

grep -oP 'HTTP/1.1" \d+ ' access.log | cut -d' ' -f2 | sort | uniq -c

91541 200

61 301

45 302

139 304

9808 403

727 404

1 500

21 502

9305 503IP相关统计

统计IP访问量

awk '{print $1}' access.log | sort -n | uniq | wc -l查看某一时间段的IP访问量(4-5点)

grep "07/Apr/2017:0[4-5]" access.log | awk '{print $1}' | sort | uniq -c| sort -nr | wc -l 查看访问最频繁的前100个IP

awk '{print $1}' access.log | sort -n |uniq -c | sort -rn | head -n 100查看访问100次以上的IP

awk '{print $1}' access.log | sort -n |uniq -c |awk '{if($1 >100) print $0}'|sort -rn查询某个IP的详细访问情况,按访问频率排序

grep '104.217.108.66' access.log |awk '{print $7}'|sort |uniq -c |sort -rn |head -n 100 页面访问统计

查看访问最频的页面(TOP100)

awk '{print $7}' access.log | sort |uniq -c | sort -rn | head -n 100查看访问最频的页面(排除php页面(TOP100)

grep -v ".php" access.log | awk '{print $7}' | sort |uniq -c | sort -rn | head -n 100 查看页面访问次数超过100次的页面

cat access.log | cut -d ' ' -f 7 | sort |uniq -c | awk '{if ($1 > 100) print $0}' | less查看最近1000条记录,访问量最高的页面

tail -1000 access.log |awk '{print $7}'|sort|uniq -c|sort -nr|less每秒请求量统计

统计每秒的请求数,top100的时间点(精确到秒)

awk '{print $4}' access.log |cut -c 14-21|sort|uniq -c|sort -nr|head -n 100每分钟请求量统计

统计每分钟的请求数,top100的时间点(精确到分钟)

awk '{print $4}' access.log |cut -c 14-18|sort|uniq -c|sort -nr|head -n 100每小时请求量统计

统计每小时的请求数,top100的时间点(精确到小时)

awk '{print $4}' access.log |cut -c 14-15|sort|uniq -c|sort -nr|head -n 100性能分析

在nginx log中最后一个字段加入$request_time

列出传输时间超过 3 秒的页面,显示前20条

cat access.log|awk '($NF > 3){print $7}'|sort -n|uniq -c|sort -nr|head -20列出php页面请求时间超过3秒的页面,并统计其出现的次数,显示前100条

cat access.log|awk '($NF > 1 && $7~/\.php/){print $7}'|sort -n|uniq -c|sort -nr|head -100蜘蛛抓取统计

统计蜘蛛抓取次数

grep 'Baiduspider' access.log |wc -l统计蜘蛛抓取404的次数

grep 'Baiduspider' access.log |grep '404' | wc -lTCP连接统计

查看当前TCP连接数

netstat -tan | grep "ESTABLISHED" | grep ":80" | wc -l用tcpdump嗅探80端口的访问看看谁最高

tcpdump -i eth0 -tnn dst port 80 -c 1000 | awk -F"." '{print $1"."$2"."$3"."$4}' | sort | uniq -c | sort -nr版权属于:毒奶

联系我们:https://limbopro.com/6.html

毒奶搜索:https://limbopro.com/search.html

番号搜索:https://limbopro.com/btsearch.html

机场推荐:https://limbopro.com/865.html IEPL专线/100Gb/¥15/月起(最高享8折优惠)

毒奶导航:https://limbopro.com/daohang/index.html本文链接:https://limbopro.com/archives/1107.html · 镜像:https://limbopro.github.io/archives/1107.html

本文采用 CC BY-NC-SA 4.0 许可协议,转载或引用本文时请遵守许可协议,注明出处、不得用于商业用途!