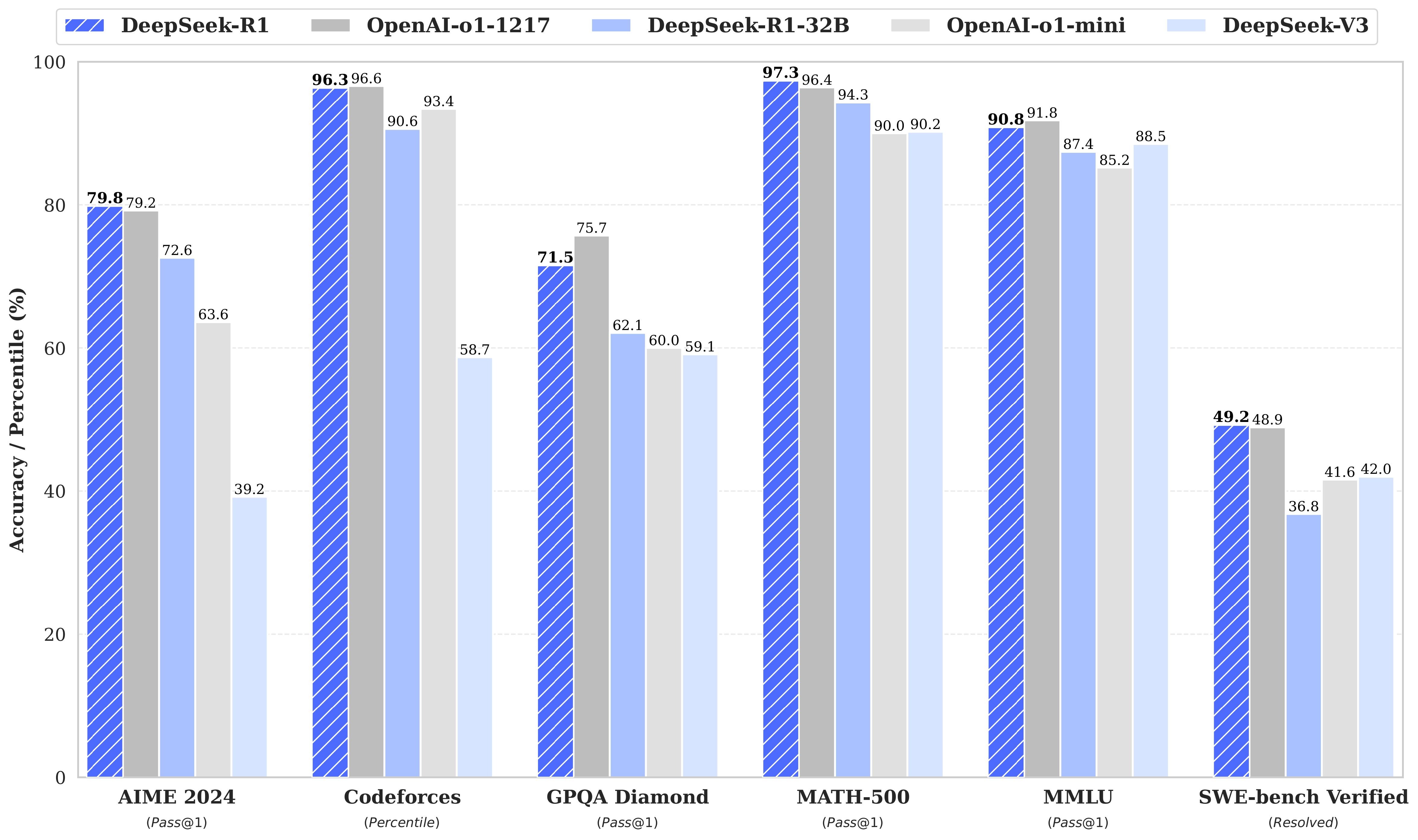

以上是 deepseek-R1 与 openai-o1 对比数据;DeepSeek-R1 在数学、代码和推理任务方面的性能可与 OpenAI-o1 相媲美;详细数据可参阅 https://github.com/deepseek-ai/DeepSeek-R1?tab=readme-ov-file#deepseek-r1-evaluation ;

DeepSeek 介绍

DeepSeek(深度求索)是一家中国的人工智能和大型语言模型公司,背后是中国对冲基金幻方量化。

公司全称:DeepSeek,全称杭州深度求索人工智能基础技术研究有限公司,成立于2023年7月17日。公司由中国知名量化资管巨头幻方量化创立,专注于开发先进的大语言模型(LLM)和相关技术,总部位于中国杭州。

创始人:梁文锋,他此前创立了幻方量化,是国内量化私募“四巨头”之一。

DeepSeek-R1 官方介绍

“我们介绍了我们的第一代推理模型 DeepSeek-R1-Zero 和 DeepSeek-R1。DeepSeek-R1-Zero 是一种通过大规模强化学习 (RL) 训练的模型,没有监督微调 (SFT) 作为初步步骤,在推理方面表现出了卓越的性能。随着 RL 的出现,DeepSeek-R1-Zero 自然而然地出现了许多强大而有趣的推理行为。然而,DeepSeek-R1-Zero 遇到了无休止的重复、可读性差和语言混合等挑战。为了解决这些问题并进一步提高推理性能,我们引入了 DeepSeek-R1,它在 RL 之前整合了冷启动数据。DeepSeek-R1 在数学、代码和推理任务方面的性能可与 OpenAI-o1 相媲美。为了支持研究社区,我们开源了 DeepSeek-R1-Zero、DeepSeek-R1 以及基于 Llama 和 Qwen 从 DeepSeek-R1 提炼出来的六个密集模型。DeepSeek-R1-Distill-Qwen-32B 在各种基准测试中都优于 OpenAI-o1-mini,为密集模型实现了新的先进结果。”

Github:https://github.com/deepseek-ai/DeepSeek-R1

本地化部署运行:https://github.com/deepseek-ai/DeepSeek-R1?tab=readme-ov-file#6-how-to-run-locally (如果你不想使用 Ollama ,你可以参阅官方 Readme 进行本地部署)

Ollama 介绍/下载/安装

启动并运行 Llama 3.3、DeepSeek-R1、Phi-4、Gemma 2 和其他大型语言模型。

Ollama 下载与安装

Ollama 常用命令参考

CLI是什么? Ollama CLI 参考,完整参阅:https://github.com/ollama/ollama/blob/main/README.md#cli-reference

ollama start

ollama run // ollama run deepseek-r1 etc.

ollama serve

ollama stop常见CLI参考;

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version informationCreate a model

创建模型

https://github.com/ollama/ollama/blob/main/README.md#create-a-model)

ollama create is used to create a model from a Modelfile.

ollama create mymodel -f ./ModelfilePull a model

https://github.com/ollama/ollama/blob/main/README.md#pull-a-model

ollama pull llama3.2This command can also be used to update a local model. Only the diff will be pulled.

Remove a model

移除模型

https://github.com/ollama/ollama/blob/main/README.md#remove-a-model

ollama rm llama3.2Copy a model

复制模型

https://github.com/ollama/ollama/blob/main/README.md#copy-a-model

ollama cp llama3.2 my-modelMultiline input

多行输入

https://github.com/ollama/ollama/blob/main/README.md#multiline-input

For multiline input, you can wrap text with """:

>>> """Hello,

... world!

... """

I'm a basic program that prints the famous "Hello, world!" message to the console.Multimodal models

多模式模型

https://github.com/ollama/ollama/blob/main/README.md#multimodal-models

ollama run llava "What's in this image? /Users/jmorgan/Desktop/smile.png"

The image features a yellow smiley face, which is likely the central focus of the picture.Pass the prompt as an argument

将提示符作为参数传递

https://github.com/ollama/ollama/blob/main/README.md#pass-the-prompt-as-an-argument

$ ollama run llama3.2 "Summarize this file: $(cat README.md)"

Ollama is a lightweight, extensible framework for building and running language models on the local machine. It provides a simple API for creating, running, and managing models, as well as a library of pre-built models that can be easily used in a variety of applications.Show model information

显示模型信息

https://github.com/ollama/ollama/blob/main/README.md#show-model-information

ollama show llama3.2List models on your computer

列出计算机上的型号

https://github.com/ollama/ollama/blob/main/README.md#list-models-on-your-computer

ollama listList which models are currently loaded

列出当前加载的机型

https://github.com/ollama/ollama/blob/main/README.md#list-which-models-are-currently-loaded

ollama psStop a model which is currently running

停止正在运行的模型

https://github.com/ollama/ollama/blob/main/README.md#stop-a-model-which-is-currently-running

ollama stop llama3.2Start Ollama

启动 Ollama

https://github.com/ollama/ollama/blob/main/README.md#start-ollama

ollama serve is used when you want to start ollama without running the desktop application.

Building

构建

https://github.com/ollama/ollama/blob/main/README.md#building

See the developer guide

Running local builds

运行本地构建

https://github.com/ollama/ollama/blob/main/README.md#running-local-builds

Next, start the server:

./ollama serveFinally, in a separate shell, run a model:

./ollama run llama3.2选择/运行大模型

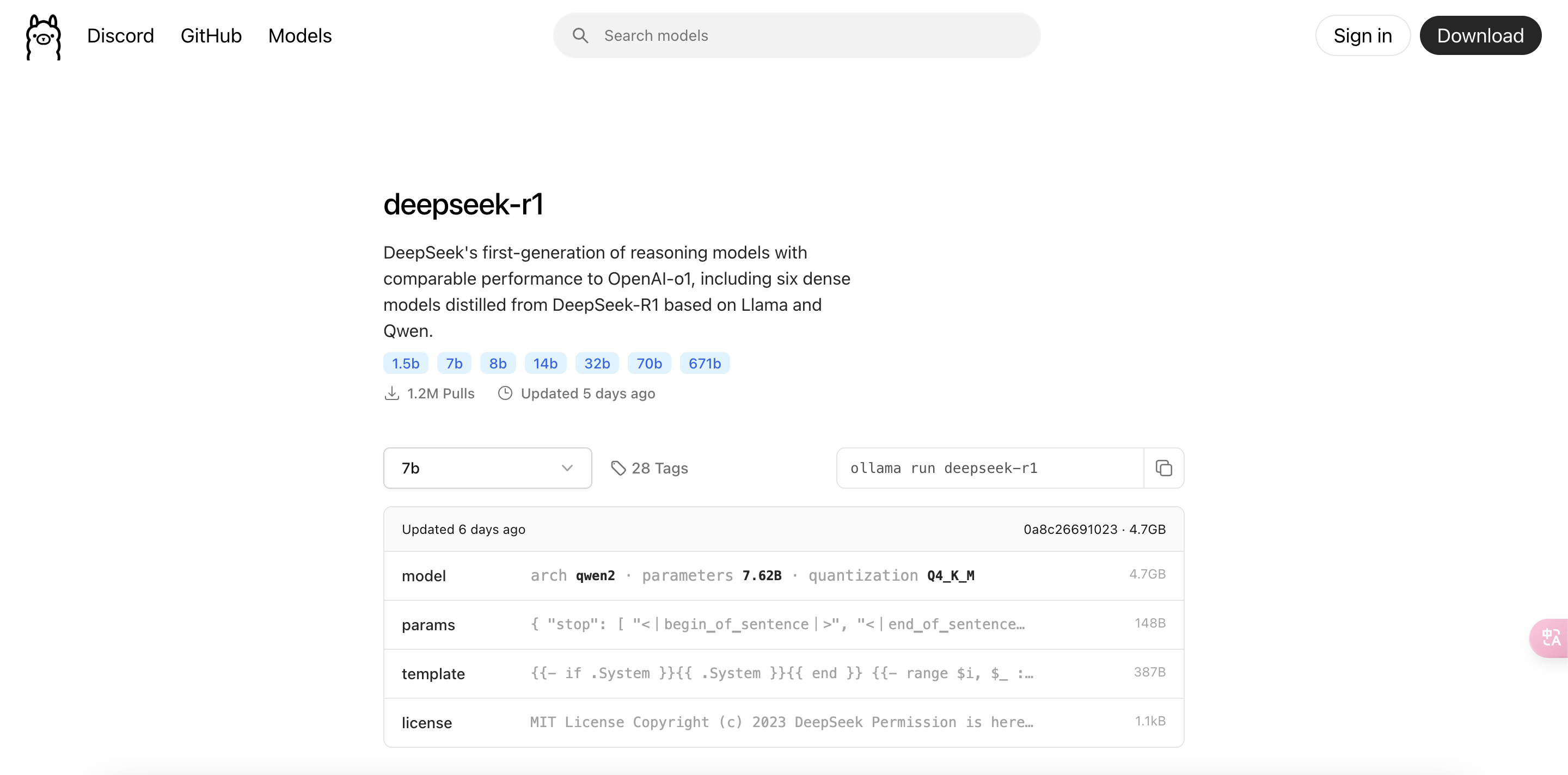

ollama run deepseek-r1

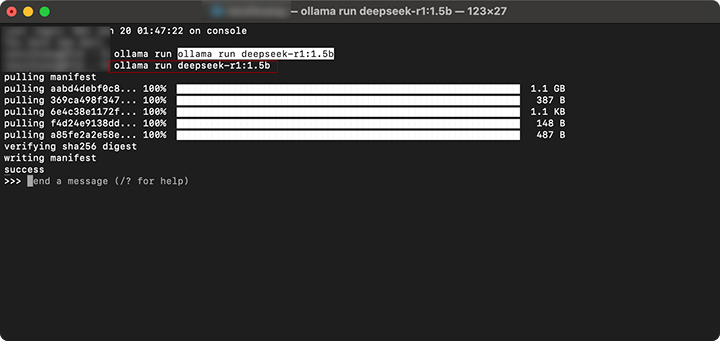

ollama run deepseek-r1:1.5b

ollama run deepseek-r1:7b

ollama run deepseek-r1:8b

ollama run deepseek-r1:14b

ollama run deepseek-r1:32b

ollama run deepseek-r1:70b

ollama run deepseek-r1:671b

博主测试安装的是 1.5b 参数版;

应该选择哪个模型?

DeepSeek R1 有多个版本,选择取决于你的的硬件:

1.5B Parameters:

RAM required: ~4 GB.

GPU: Integrated (like NVIDIA GTX 1050) or a modern CPU.

What for?: Simple tasks and modest PCs.

7B Parameters:

RAM required: ~8-10 GB.

GPU: Dedicated (like NVIDIA GTX 1660 or better).

What for?: Intermediate tasks and PCs with better hardware.

70B Parameters:

RAM required: ~40 GB.

GPU: High-end (like NVIDIA RTX 3090 or higher).

What for?: Complex tasks and super powerful PCs.You should have at least 8 GB of RAM available to run the 7B models, 16 GB to run the 13B models, and 32 GB to run the 33B models.

您应该至少有 8 GB 的 RAM 来运行 7B 型号,16 GB 的 RAM 来运行 13B 的型号,32 GB 的 RAM 来运行 33B 型号。

以上是 Ollama 给出的建议;

或运行自定义模型

除了 Ollama 原生支持的大模型外,如何导入自定义模型:从 GGUF 导入,Ollama 支持在模型文件中导入 GGUF 模型:参阅 Read.me https://github.com/ollama/ollama/blob/main/README.md#customize-a-model customize-a-model 部分;

对话测试

>>> 帮我写篇300字的小短文,包含夏天,教室,女教师

<think>

好的,我现在需要帮用户写一篇300字的小短文。首先,我得理解用户的需求。

用户的目标是写一篇关于夏天、教室和女教师的小短文。考虑到是300字左右,所以需要简洁明了。我得构思一个场景,让读者感受到那种氛围。

首先,夏天通常让人联想到高温和阳光,所以描述一下闷热的教室环境,透过窗户看到树叶的影子,绿色的教桌和黑板上跳动的光线,这样能营造出明亮但又有点燥热的感觉。

然后,女教师应该是故事的核心人物,她用温暖的目光照亮学生,耐心解答问题,这体现了她的风范。这样可以让读者感受到老师的关怀和教育意义。

接下来,我需要加入一些互动,比如学生举手回答问题,展示他们在学习上的进步,以及老师对此的鼓励,让整个场景更有生气和希望。

最后,要点题,说明夏天虽然炎热,但教室里却充满了知识和成长的力量,这样的结尾既呼应了主题,又给人以积极向上的感觉。

在写作时,要注意语言简洁,用词要生动,让读者有身临其境的感觉。同时,确保整体流畅,不遗漏关键元素。

现在,我需要把这些想法组织成一篇连贯的小短文,大概分为几个段落:环境描写、教师的形象、学生互动和结尾总结。

检查一下是否有重复或不必要的部分,确保每个句子都紧扣主题,不跑题。最后,估算字数,看看是否符合300字左右,进行适当调整。

完成后,再通读一遍,确保语句通顺,没有错别字或错误,确保整体感受和用户的期望相符。

</think>

夏天总是格外闷热,每到这个时节,我就能从教室里看到阳光透过窗户洒在课桌上的影子。那些微微颤动的光线仿佛在跳舞,黑板上闪烁着细碎的金光。

我喜欢坐在靠近窗边的位置,这样能看到树叶在风中轻轻摇晃,阳光斑驳地洒在地面上。空气里飘荡着粉笔的清香,混合着一丝若有若无的消毒水味道。

教室里总是安静得可怕,只有粉笔在黑板上划出字句的声音,有时也会传来学生递交作业时发出的沙沙声。女教师站在讲台上,身影被阳光拉得很长,她的目光温暖而坚定地扫过我们每个人。

有时,当她讲解复杂的知识点时,我能看到她的手势在空中划出优美的弧线,就像一位指挥家为音乐赋予了生命。她的声音轻柔细腻,总能让那些枯燥的公式和定理变得生动起来。

阳光透过树叶的缝隙,在她侧面投下斑驳的影子,看上去就像是在跳着优雅的舞蹈。她的笑容如同清晨的露珠般清新,总能让整个教室充满欢声笑语。

有时候,我会抬头看向她,她正在认真地批改作业,眉头微蹙,却又不失温和。她总是耐心解答学生的问题,甚至在课后主动为他们布置辅导时间。

有一次,我忘记带笔到了课堂上,正发愁的时候,女教师从自己的书包里拿出一支彩色笔递给我,说:“学习就是这样,一直在路上。”这句话至今让我记忆深刻,她的善意和鼓励让我倍感温暖。

教室里的风轻轻拂过,带来一丝凉意。透过窗户,我能看到蝉鸣声由远及近,它们仿佛在和女教师一起演奏着一首无声的乐章。

这个夏天,就这样在老师的指引下,我们一起走向知识的海洋,虽然路途或许漫长,但每一步都充满希望。教室里那些微弱的灯光,总能照亮我们前行的方向。

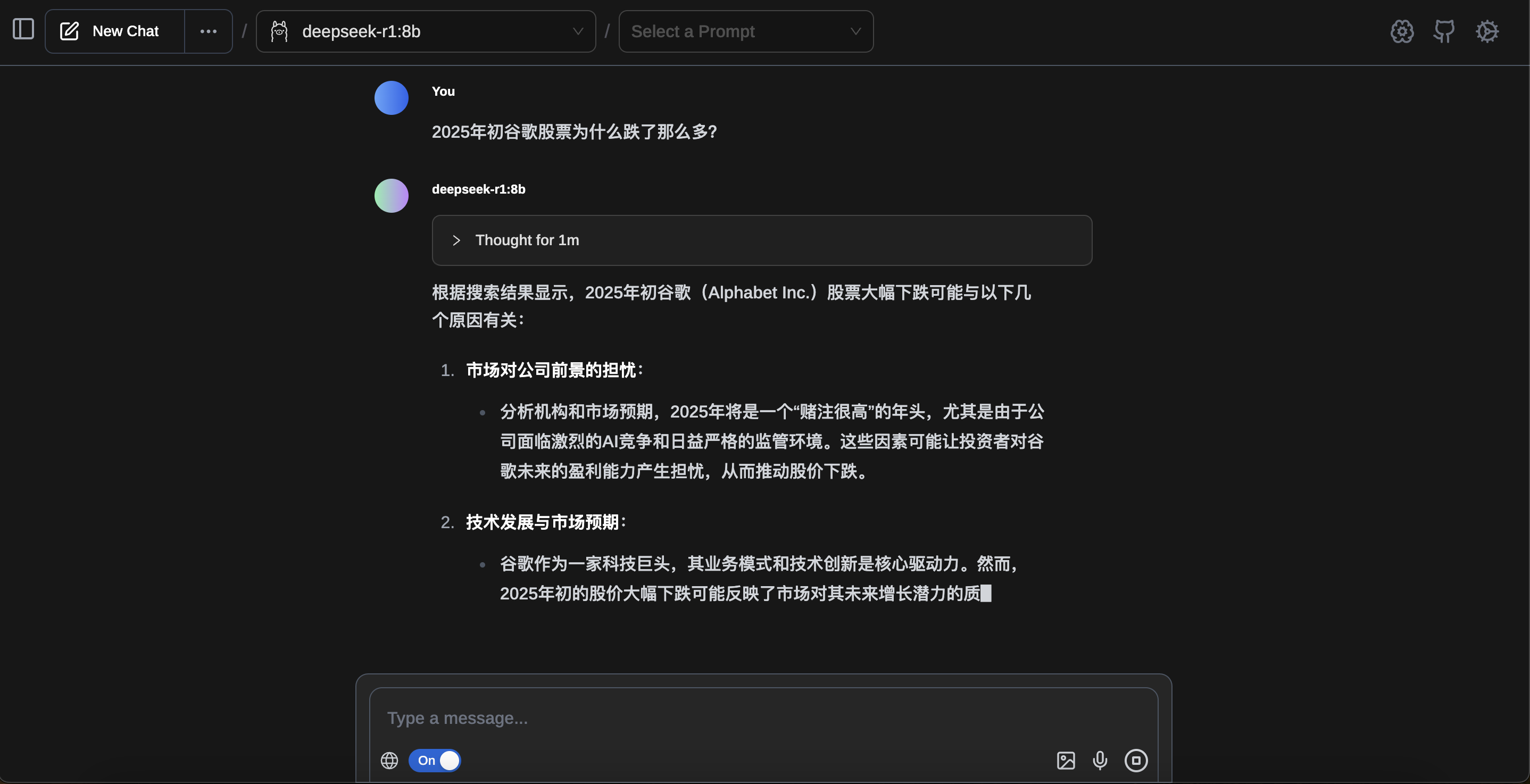

以上,<think></think> 内是“思考/推理”的过程,这点真的很有意思,而这是chatGPT没有的。

Okkk!快去试试吧!

DeepSeek-R1 联网扩展

https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo?hl=zh-CN&utm_source=ext_sidebar

1.安装完成后,置顶该扩展 Page Assist;

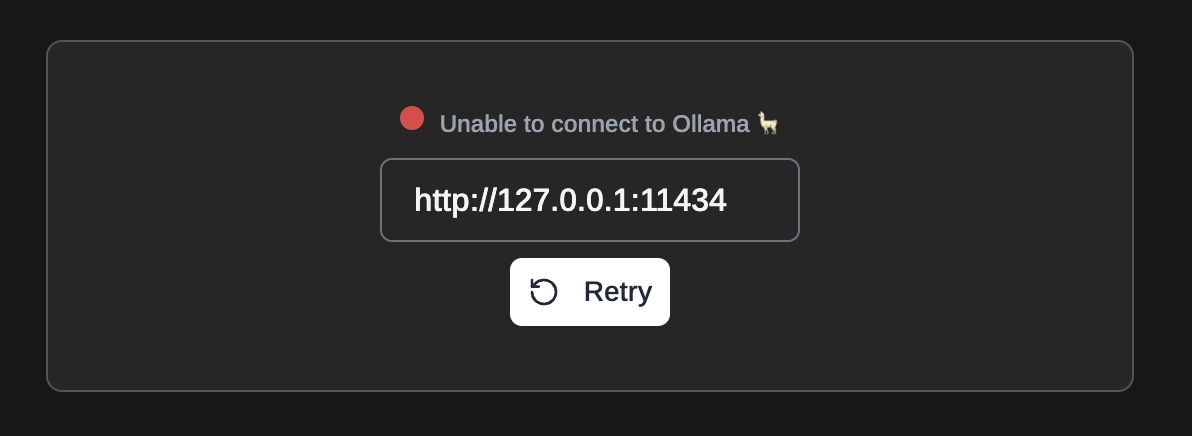

2.点击 Page Assist 进入Chat页面 连接 Ollama http://127.0.0.1:11434 (举例);

3.请确保 Ollama 已经运行且已经运行大模型,(如需知道 Ollama 运行状态可 参阅本文 Ollama 常用命令参考)

ollama start

ollama serve

ollama run // ollama run deepseek-r1 etc.

ollama stop常见CLI参考;

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

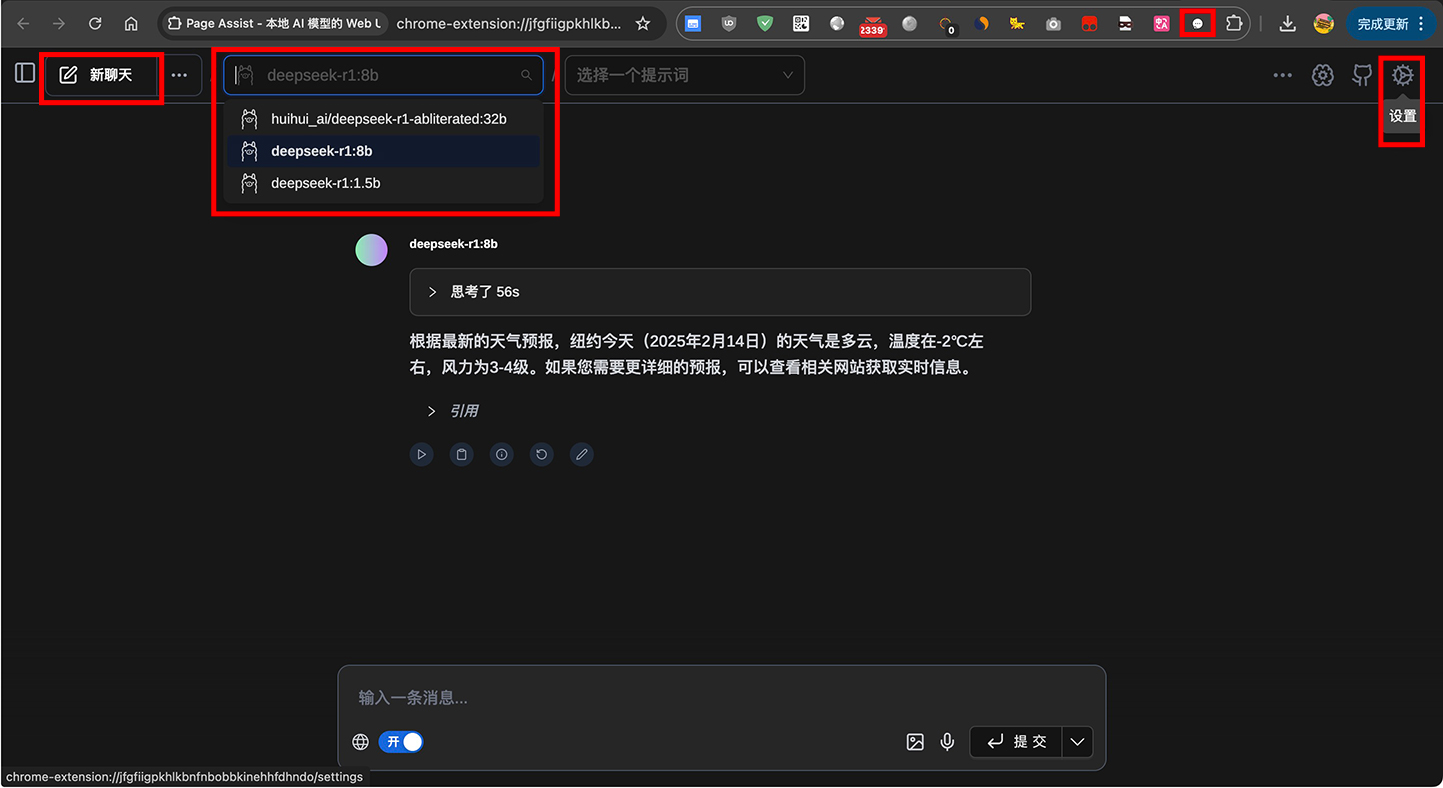

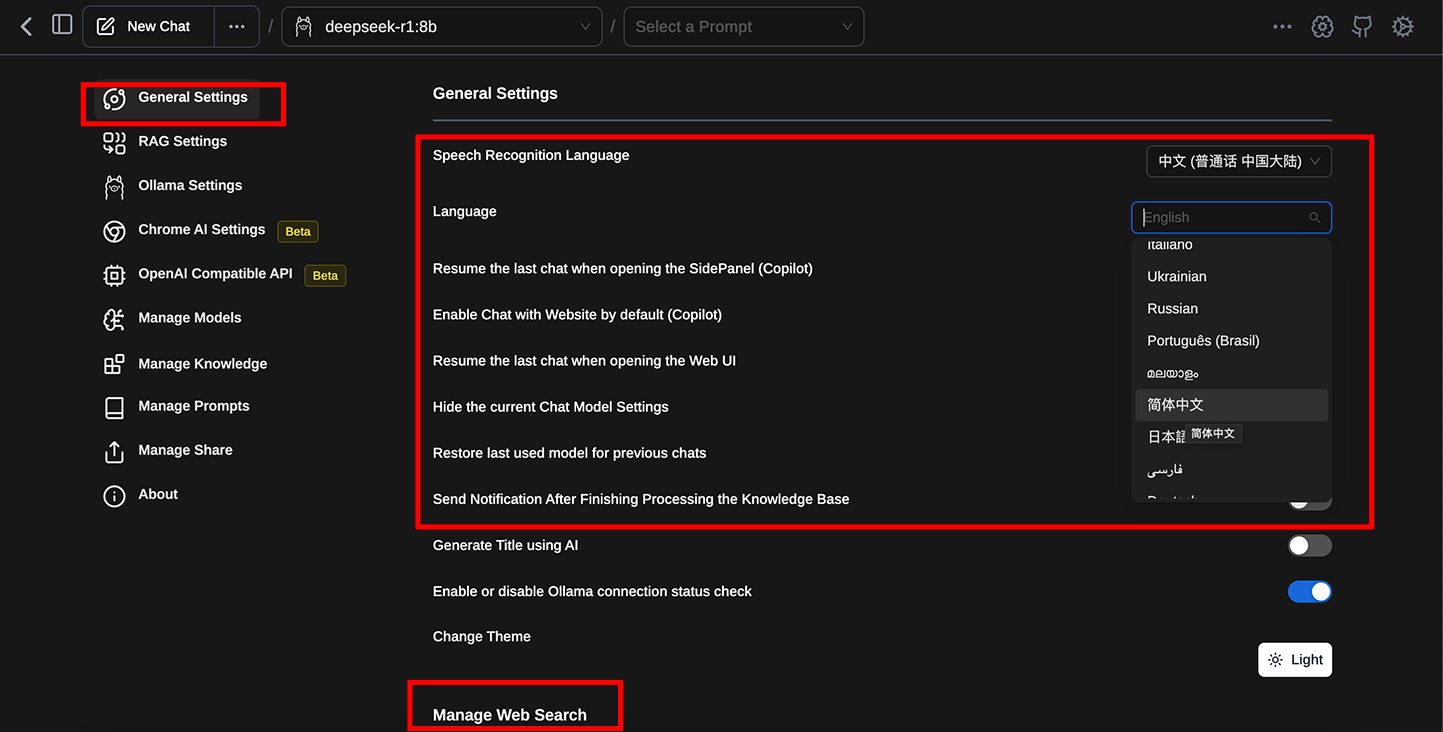

4.如上图;Page Assist 连接 Ollama 成功后即可正常联网使用;

5.补充更新;如上图;Page Assist - 设置-> 联网搜索的搜索引擎设置/语言设置/模型选择等;选择适当的搜索引擎可以得到较好的联网搜索体验;(具体视你本地网络环境而定,请确保你的浏览器能正常打开相应搜索引擎且无需验证码;)

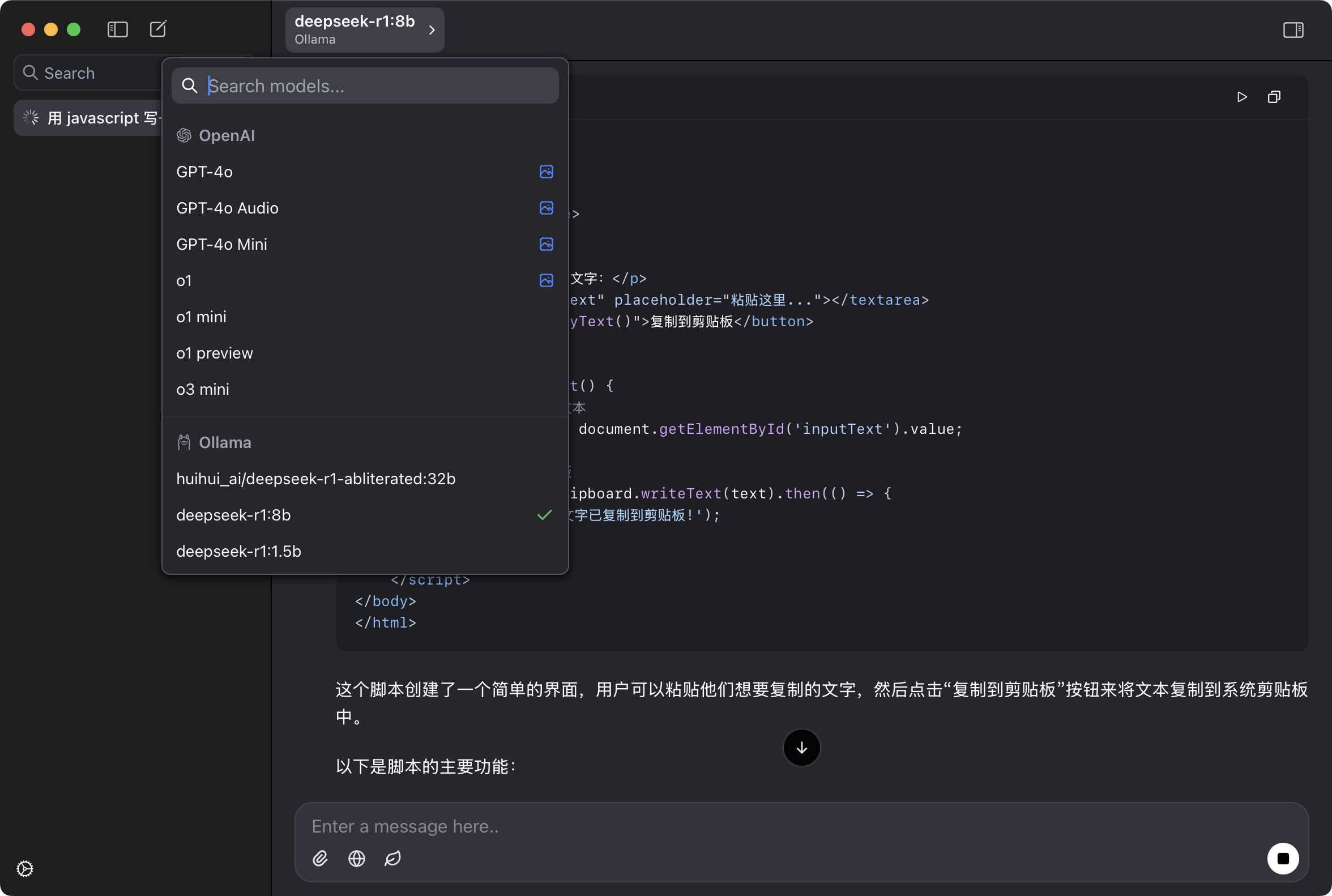

部署 Web-UI

按本文 DeepSeek-R1 联网扩展 部分操作其实已经可以得到一个不错的 Chat UI 了;如果想要有 chatGPT 那样的交互界面(对话/上传文本/PDF/图片等),可自行部署 WebUI;这里推荐 Open WebUI 以及 ChatWise 两种方式;(如何配置详见下文)

Open WebUI

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种LLM运行器,如 Ollama 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。

Open WebUI ⭐ 的主要特点:

🚀 轻松设置:使用 Docker 或 Kubernetes(kubectl、kustomize 或 helm)无缝安装,支持 :ollama 和 :cuda 标记的映像,获得轻松的体验。

🤝 Ollama/OpenAI API 集成:轻松集成与 OpenAI 兼容的 API,与 Ollama 模型一起进行多功能对话。自定义 OpenAI API URL 以与 LMStudio、GroqCloud、Mistral、OpenRouter 等链接。

🛡️ 精细权限和用户组:通过允许管理员创建详细的用户角色和权限,我们确保安全的用户环境。这种粒度不仅增强了安全性,还允许自定义用户体验,从而在用户中培养主人翁意识和责任感。

...

以下是配合 Ollama 一起食用的方法;

安装 Docker

按需安装相应平台的 Docker 版本 https://docs.docker.com/desktop/setup/install/mac-install/ ;

安装完成后(运行 Docker,按软件提示配置好运行环境),进入 终端 ,输入如下命令:

docker version如果正常输入 docker 的版本,则可以继续下一步;

安装 Open WebUI

如果 Ollama 在您的计算机上,请使用以下命令:(可参阅完整安装文档),在终端输入如下命令以安装 Open WebUI;

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main一切搞定后,访问:http://localhost:3000/auth ,如下图所示;

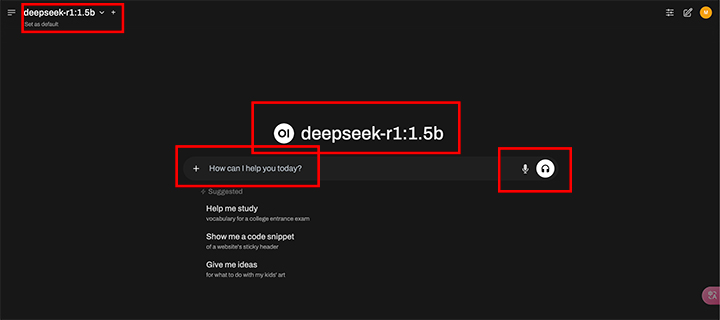

ChatWise

ChatWise 可配合 Ollama 使用(无需登陆 ChatWise),如需联网使用深度搜索需要升级 Price plan;请确保 Ollama 已经运行且已经运行大模型,(如需知道 Ollama 运行状态可 参阅本文 Ollama 常用命令参考)

DeepSeek API 文档

探索 DeepSeek 提示词样例,挖掘更多可能

代码改写

对代码进行修改,来实现纠错、注释、调优等。

代码解释

对代码进行解释,来帮助理解代码内容。

代码生成

让模型生成一段完成特定功能的代码。

内容分类

对文本内容进行分析,并对齐进行自动归类

结构化输出

将内容转化为 Json,来方便后续程序处理

角色扮演(自定义人设)

自定义人设,来与用户进行角色扮演。

角色扮演(情景续写)

提供一个场景,让模型模拟该场景下的任务对话

散文写作

让模型根据提示词创作散文

诗歌创作

让模型根据提示词,创作诗歌

文案大纲生成

根据用户提供的主题,来生成文案大纲

宣传标语生成

让模型生成贴合商品信息的宣传标语。

模型提示词生成

根据用户需求,帮助生成高质量提示词

中英翻译专家

中英文互译,对用户输入内容进行翻译

DeepSeek 模型 & 价格

API 是什么?

参阅;

DeepSeek 价格

参阅:https://api-docs.deepseek.com/zh-cn/quick_start/pricing 注:本地部署 DeepSeek-R1 推理模型是不要钱的,使用到的模型开源的,它并不会调用到 DeepSeek 的 API,结果的输出/生成速度和质量完全基于你的电脑算力以及你的提问水平;

chatgpt 价格

参阅:https://openai.com/chatgpt/pricing/

Google Gemini 价格

参阅:https://ai.google.dev/pricing

Claude 价格

参阅:https://www.anthropic.com/pricing

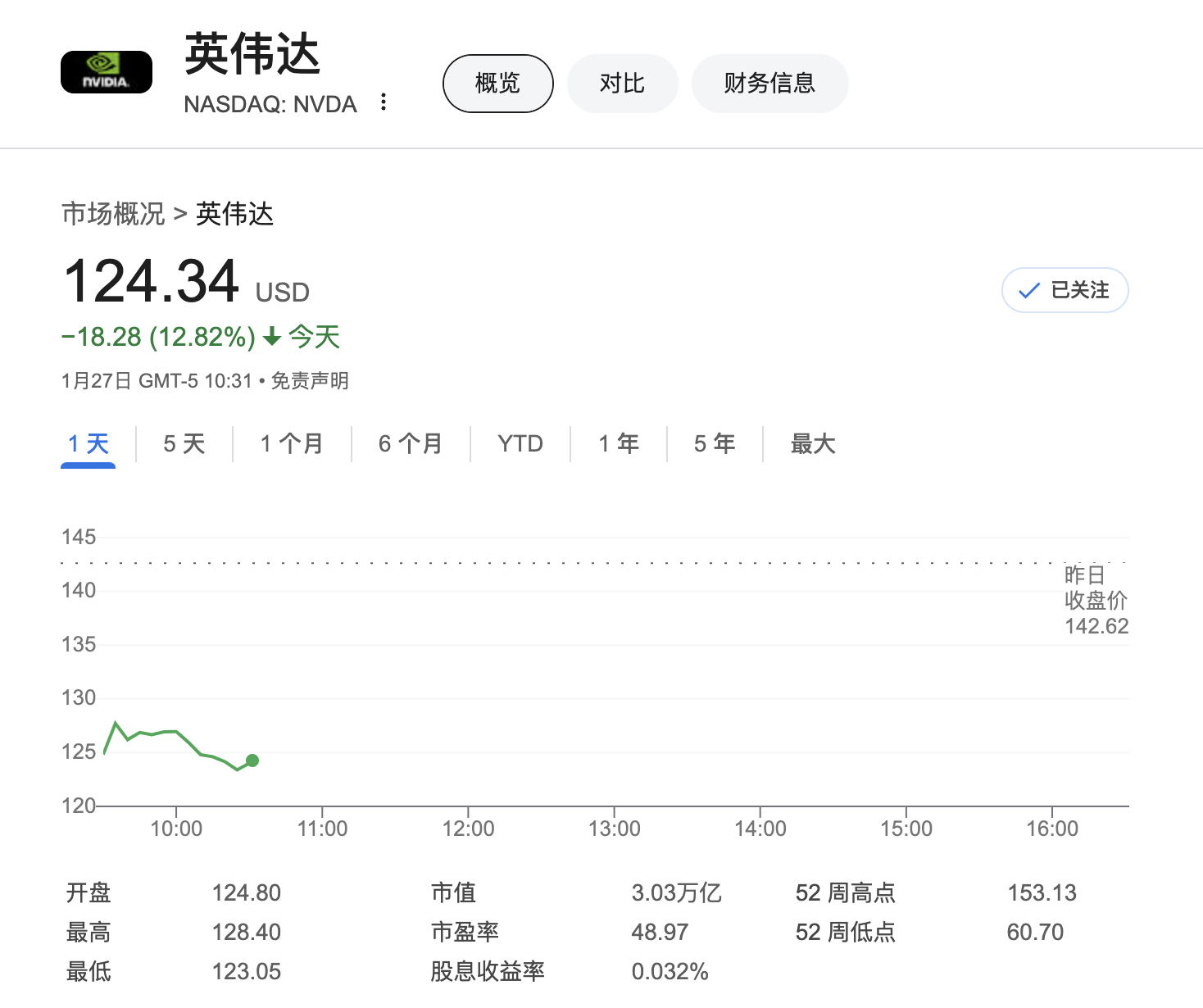

市场反应

Faq

如果你英语不是很好,可以安装 沉浸式翻译 插件;

其他:暂无;

版权属于:毒奶

联系我们:https://limbopro.com/6.html

毒奶搜索:https://limbopro.com/search.html

番号搜索:https://limbopro.com/btsearch.html

机场推荐:https://limbopro.com/865.html IEPL专线/100Gb/¥15/月起(最高享8折优惠)

毒奶导航:https://limbopro.com/daohang/index.html本文链接:https://limbopro.com/archives/31642.html · 镜像:https://limbopro.github.io/archives/31642.html

本文采用 CC BY-NC-SA 4.0 许可协议,转载或引用本文时请遵守许可协议,注明出处、不得用于商业用途!